FUNDAMENTOS DE LA IA

FUNDAMENTOS DE LA IA

FUNDAMENTOS

Conceptos y recursos interactivos para entender cómo funciona la inteligencia artificial: desde qué es la IA generativa y los modelos de lenguaje, hasta neuronas artificiales, perceptrones, transformadores y una línea de tiempo de su desarrollo.

El camino de la IA Generativa

Qué es un agente de IA

Qué es un bot

Qué es el aprendizaje automático

Qué es el procesamiento de lenguaje natural

Procesamiento de lenguaje natural

¿Qué es?

El procesamiento de lenguaje natural es una rama de las ciencias de la computación y la inteligencia artificial que se centra en brindar a las computadoras la capacidad de interpretar, comprender, manipular e interpretar el lenguaje humano.

La lingüística computacional es una ciencia que estudia los aspectos computacionales del lenguaje humano, mientras que el procesamiento de lenguaje natural es una rama que se concentra en construir artefactos computacionales que entiendan, generen o manipulen el lenguaje humano.

Hay dos subcategorías: comprensión del lenguaje natural (NLU) y generación de lenguaje natural (NLG). NLU se centra en entender la intención comunicativa, significado y contexto del texto en vez del significado individual de las palabras mediante del análisis sintáctico y semántico. Por otra parte, NLG se centra en crear salidas (output) en lenguaje natural, haciendo posible la interacción entre computadoras y humanos.

¿Cómo funciona?

El procesamiento de lenguaje natural combina la lingüística computacional con algoritmos de aprendizaje. La lingüística computacional usa ciencia de datos para analizar el idioma y el habla, incluyendo dos tipos de análisis: sintáctico y semántico.

Análisis sintáctico determina el significado de una palabra, frase u oración analizando la sintaxis de las palabras y aplicando reglas gramaticales preestablecidas. El análisis semántico utiliza el resultado sintáctico para extraer el significado de las palabras e interpretar su significado dentro de la estructura de la oración.

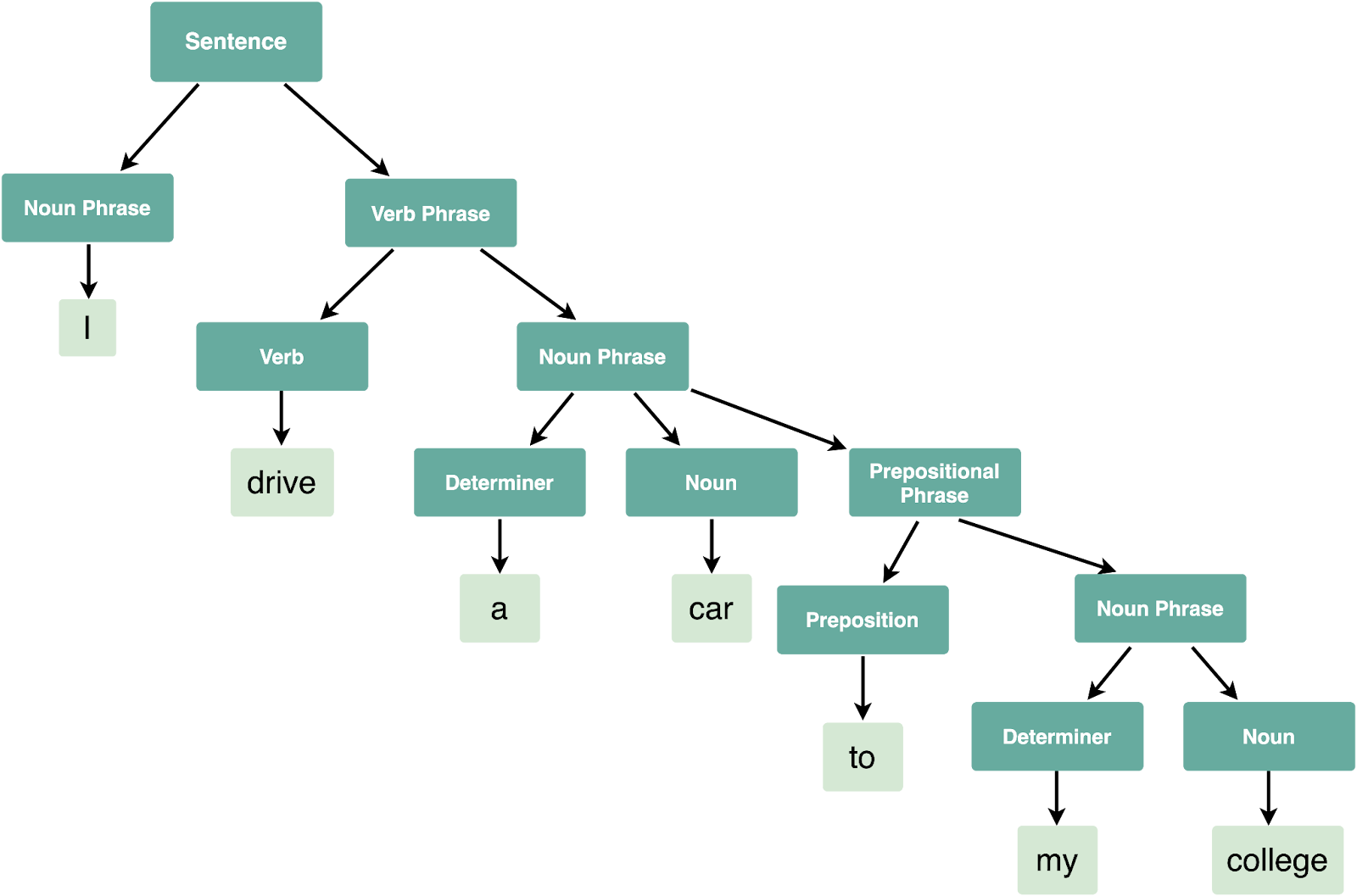

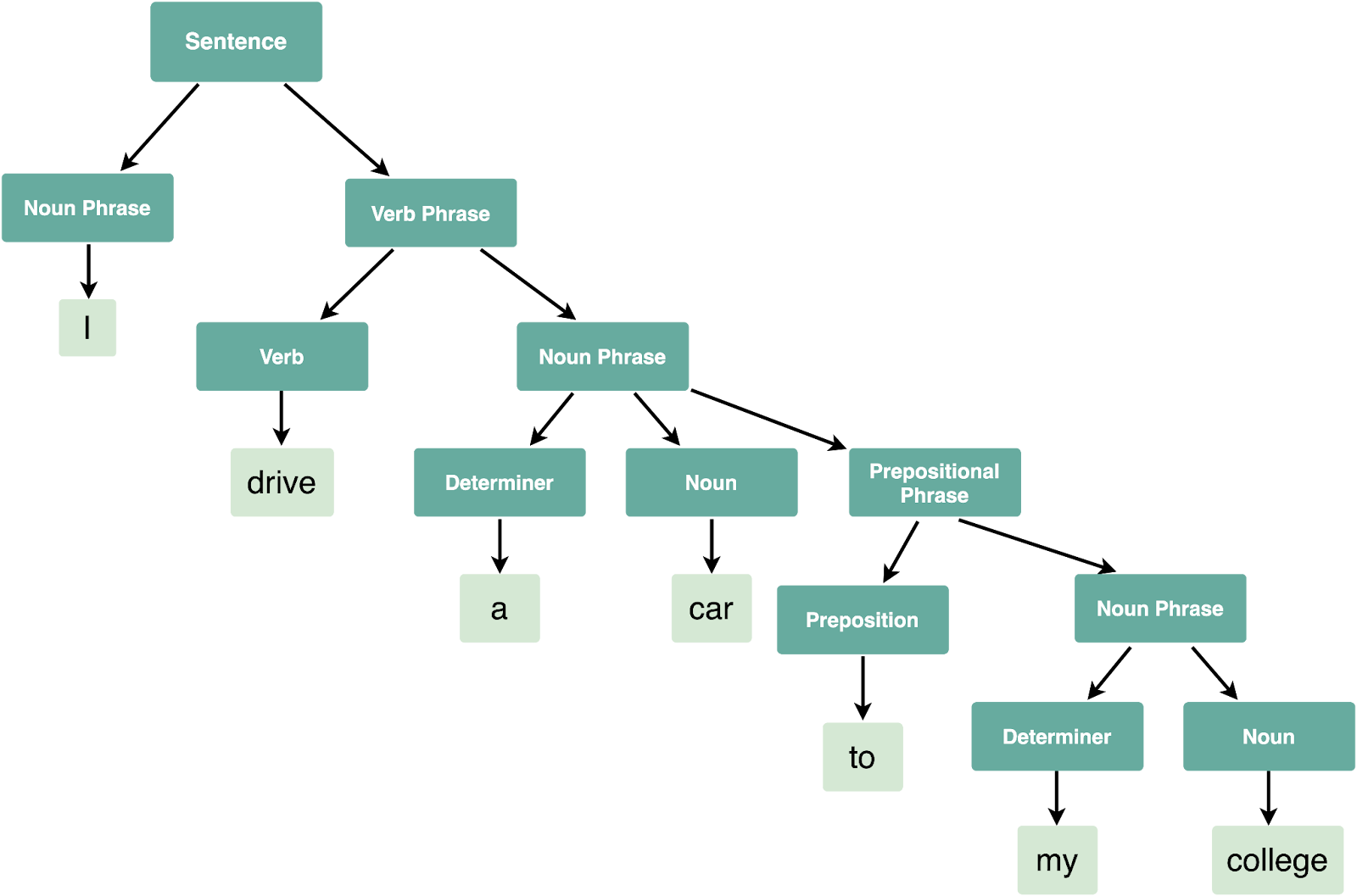

El análisis puede ser de dos formas: el análisis de dependencia busca las relaciones entre palabras, como identificar sustantivos y verbos, mientras que el análisis de constituyentes arma un árbol sintáctico: una representación ordenada de la estructura sintáctica de la oración, ayudando a la traducción y reconocimiento del habla.

Otra herramienta es la normalización de texto: como el lenguaje natural puede contener aleatoriedad, la normalización ayuda a reducirla y acercarla a un estándar. Por ejemplo, al buscar en Google “como aprender ingles”, “cómo aprender inglés”, “cómo aprender inglés?” y “¿como aprender inglés?”, los resultados serán los mismos.

Una forma de normalización son los “tokens”. En español, las palabras usualmente están separadas por espacios, pero a veces no es suficiente. “Fuegos artificiales” o “Buenos Aires”, por más que están separados por espacios, se refieren al mismo concepto. Los LLM usan tokens que varían en tamaño, desde letras, subpalabras (partes de palabras) a palabras enteras o frases cortas.

Otra herramienta es la lematización, la tarea de determinar que dos palabras tienen la misma raíz, por más que parezcan diferentes. Por ejemplo, “fui” y “seríamos” tienen la misma raíz: el verbo “ser”.

¿Para qué sirve?

El procesamiento de lenguaje natural permitió el inicio de la era generativa de la inteligencia artificial, desde la capacidad de comunicación de los grandes modelos de lenguaje (LLM) a la habilidad de generación de imágenes para entender mejor la petición del usuario. Forman parte de los chatbots (como atención al cliente), asistentes digitales en smartphones o traductores.

Su principal aporte es el entender la intención comunicativa de la petición del usuario, de manera que pueda proveer resultados más precisos y relevantes. En vez de confiar únicamente en coincidir palabras, el procesamiento de lenguaje de palabras analiza el significado de palabras o frases, de manera que se pueda encontrar información fácilmente cuando la petición del usuario es vaga o muy compleja.

Ejemplos en la actualidad

La mayoría de consumidores probablemente hayan interactuado con el procesamiento de lenguaje sin darse cuenta. Por ejemplo, es la tecnología de fondo de asistentes virtuales, Siri, Cortana, Alexa, buscadores como Google o chatbots.

Bibliografía:

What Is NLP (Natural Language Processing)? | IBM

¿Qué es el Procesamiento de lenguaje natural (NLP)?

What is Natural Language Understanding (NLU)? | IBM

What is Natural Language Generation (NLG)? | IBM

What Is Document Processing? | IBM

El camino de la IA Generativa

Qué es un agente de IA

Qué es un bot

Qué es el aprendizaje automático

Qué es el procesamiento de lenguaje natural

Procesamiento de lenguaje natural

¿Qué es?

El procesamiento de lenguaje natural es una rama de las ciencias de la computación y la inteligencia artificial que se centra en brindar a las computadoras la capacidad de interpretar, comprender, manipular e interpretar el lenguaje humano.

La lingüística computacional es una ciencia que estudia los aspectos computacionales del lenguaje humano, mientras que el procesamiento de lenguaje natural es una rama que se concentra en construir artefactos computacionales que entiendan, generen o manipulen el lenguaje humano.

Hay dos subcategorías: comprensión del lenguaje natural (NLU) y generación de lenguaje natural (NLG). NLU se centra en entender la intención comunicativa, significado y contexto del texto en vez del significado individual de las palabras mediante del análisis sintáctico y semántico. Por otra parte, NLG se centra en crear salidas (output) en lenguaje natural, haciendo posible la interacción entre computadoras y humanos.

¿Cómo funciona?

El procesamiento de lenguaje natural combina la lingüística computacional con algoritmos de aprendizaje. La lingüística computacional usa ciencia de datos para analizar el idioma y el habla, incluyendo dos tipos de análisis: sintáctico y semántico.

Análisis sintáctico determina el significado de una palabra, frase u oración analizando la sintaxis de las palabras y aplicando reglas gramaticales preestablecidas. El análisis semántico utiliza el resultado sintáctico para extraer el significado de las palabras e interpretar su significado dentro de la estructura de la oración.

El análisis puede ser de dos formas: el análisis de dependencia busca las relaciones entre palabras, como identificar sustantivos y verbos, mientras que el análisis de constituyentes arma un árbol sintáctico: una representación ordenada de la estructura sintáctica de la oración, ayudando a la traducción y reconocimiento del habla.

Otra herramienta es la normalización de texto: como el lenguaje natural puede contener aleatoriedad, la normalización ayuda a reducirla y acercarla a un estándar. Por ejemplo, al buscar en Google “como aprender ingles”, “cómo aprender inglés”, “cómo aprender inglés?” y “¿como aprender inglés?”, los resultados serán los mismos.

Una forma de normalización son los “tokens”. En español, las palabras usualmente están separadas por espacios, pero a veces no es suficiente. “Fuegos artificiales” o “Buenos Aires”, por más que están separados por espacios, se refieren al mismo concepto. Los LLM usan tokens que varían en tamaño, desde letras, subpalabras (partes de palabras) a palabras enteras o frases cortas.

Otra herramienta es la lematización, la tarea de determinar que dos palabras tienen la misma raíz, por más que parezcan diferentes. Por ejemplo, “fui” y “seríamos” tienen la misma raíz: el verbo “ser”.

¿Para qué sirve?

El procesamiento de lenguaje natural permitió el inicio de la era generativa de la inteligencia artificial, desde la capacidad de comunicación de los grandes modelos de lenguaje (LLM) a la habilidad de generación de imágenes para entender mejor la petición del usuario. Forman parte de los chatbots (como atención al cliente), asistentes digitales en smartphones o traductores.

Su principal aporte es el entender la intención comunicativa de la petición del usuario, de manera que pueda proveer resultados más precisos y relevantes. En vez de confiar únicamente en coincidir palabras, el procesamiento de lenguaje de palabras analiza el significado de palabras o frases, de manera que se pueda encontrar información fácilmente cuando la petición del usuario es vaga o muy compleja.

Ejemplos en la actualidad

La mayoría de consumidores probablemente hayan interactuado con el procesamiento de lenguaje sin darse cuenta. Por ejemplo, es la tecnología de fondo de asistentes virtuales, Siri, Cortana, Alexa, buscadores como Google o chatbots.

Bibliografía:

What Is NLP (Natural Language Processing)? | IBM

¿Qué es el Procesamiento de lenguaje natural (NLP)?

What is Natural Language Understanding (NLU)? | IBM

What is Natural Language Generation (NLG)? | IBM

What Is Document Processing? | IBM